–Ґ–µ—Е–љ–Є—З–µ—Б–Ї–Є–µ –Њ—И–Є–±–Ї–Є, –Ї–Њ—В–Њ—А—Л–µ –і–Њ–ї–ґ–љ—Л –±—Л—В—М –≤—Л—П–≤–ї–µ–љ—Л –Є —Г—Б—В—А–∞–љ–µ–љ—Л –њ—А–Є –≤–љ—Г—В—А–µ–љ–љ–µ–є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —Б–∞–є—В–∞

–Ґ–∞–Ї –ґ–µ –љ–∞ —Б—В–∞–і–Є–Є –≤–љ—Г—В—А–µ–љ–љ–µ–є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —Б–∞–є—В–∞ –Њ—З–µ–љ—М –≤–∞–ґ–љ–Њ –≤—Л—П–≤–Є—В—М –Є —Г—Б—В—А–∞–љ–Є—В—М —В–µ—Е–љ–Є—З–µ—Б–Ї–Є–µ –њ—А–Њ–±–ї–µ–Љ—Л –≤ —А–∞–±–Њ—В–µ —Б–∞–є—В–∞ –Є –љ–∞—Б—В—А–Њ–µ–Ї —Б–µ—А–≤–µ—А–∞. –Ъ –љ–Є–Љ –Њ—В–љ–Њ—Б—П—В—Б—П —Б–ї–µ–і—Г—О—Й–Є–µ –њ–∞—А–∞–Љ–µ—В—А—Л –Є –љ—О–∞–љ—Б—Л.

–Ю–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П –≤—А–µ–Љ–µ–љ–Є –Ј–∞–≥—А—Г–Ј–Ї–Є —Б—В—А–∞–љ–Є—Ж —Б–∞–є—В–∞. –Ц–µ–ї–∞—В–µ–ї—М–љ–Њ, —З—В–Њ–±—Л –≤—А–µ–Љ—П –Ј–∞–≥—А—Г–Ј–Ї–Є —Б—В—А–∞–љ–Є—Ж —Б–∞–є—В–∞ –љ–µ –њ—А–µ–≤—Л—И–∞–ї–Њ 1 —Б–µ–Ї—Г–љ–і—Г. –Т –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б–ї—Г—З–∞—П—Е –њ—А–Є –Ј–∞–≥—А—Г–Ј–Ї–µ –±–Њ–ї—М—И–Є—Е —Б—В—А–∞–љ–Є—Ж –Љ–Њ–ґ–љ–Њ, —З–Њ–±—Л –≤—А–µ–Љ—П –Ј–∞–≥—А—Г–Ј–Ї–Є –љ–µ –њ—А–µ–≤—Л—И–∞–ї–Њ 3-–µ—Е —Б–µ–Ї—Г–љ–і.

–Ъ–Њ—А—А–µ–Ї—В–љ—Л–є –Њ—В–≤–µ—В —Б–µ—А–≤–µ—А–∞ –њ—А–Є –Ј–∞–≥—А—Г–Ј–Ї–µ —Б—В—А–∞–љ–Є—Ж. –Я—А–Є –Њ—В–і–∞—З–µ —Б—В—А–∞–љ–Є—Ж—Л, —Б–µ—А–≤–µ—А —Б–Њ–Њ–±—Й–∞–µ—В —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–є –Ї–Њ–і:

200 – —Б—В—А–∞–љ–Є—Ж–∞ –і–Њ—Б—В—Г–њ–љ–∞, —В–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є –Є–љ–і–µ–Ї—Б–Є—А—Г—О—В.

301 – —Б—В—А–∞–љ–Є—Ж–∞ –њ–µ—А–µ–µ—Е–∞–ї–∞ –љ–∞–≤—Б–µ–≥–і–∞ –Є —В–µ–њ–µ—А—М –і–Њ—Б—В—Г–њ–љ–∞ –њ–Њ –і—А—Г–≥–Њ–Љ—Г –∞–і—А–µ—Б—Г, –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—М—Б—П —А–µ–і–Є—А–µ–Ї—В –љ–∞ –љ–Њ–≤—Л–є –∞–і—А–µ—Б. –Я–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є –Є–љ–і–µ–Ї—Б–Є—А—Г—О—В —Б—В—А–∞–љ–Є—Ж—Л –њ–Њ –љ–Њ–≤–Њ–Љ—Г –∞–і—А–µ—Б—Г, –њ—А–Є —Н—В–Њ–Љ –Њ–±—Л—З–љ–Њ —Г—З–Є—В—Л–≤–∞—О—В –≤–µ—Б –Є –≤–Њ–Ј—А–∞—Б—В —Б—В–∞—А—Л—Е —Б—В—А–∞–љ–Є—Ж. –Я–Њ—Н—В–Њ–Љ—Г –і–∞–љ–љ—Л–є —Б–њ–Њ—Б–Њ–± —Е–Њ—А–Њ—И–Њ –њ–Њ–і—Е–Њ–і–Є—В –њ—А–Є —Б–Љ–µ–љ–µ –∞–і—А–µ—Б–∞ —Б–∞–є—В–∞ –ї–Є–±–Њ –≤–Є–і–∞ –∞–і—А–µ—Б–Њ–≤ —Б—В—А–∞–љ–Є—Ж –љ–∞ —Б–∞–є—В–µ.

404 – —Б—В—А–∞–љ–Є—Ж–∞ –љ–µ –і–Њ—Б—В—Г–њ–љ–∞. –Ю–±—Л—З–љ–∞—П —В–∞–Ї–∞—П –Њ—И–Є–±–Ї–∞ –њ—А–Њ–Є—Б—Е–Њ–і–Є—В, –Ї–Њ–≥–і–∞ –≤–≤–µ–і–µ–љ –љ–µ –њ—А–∞–≤–Є–ї—М–љ—Л–є –∞–і—А–µ—Б —Б—В—А–∞–љ–Є—Ж—Л (URL). –Я—А–Є –≤–≤–Њ–і–µ –љ–µ–њ—А–∞–≤–Є–ї—М–љ–Њ–≥–Њ –∞–і—А–µ—Б–∞ —Б—В—А–∞–љ–Є—Ж—Л, –Ї–Њ–і –љ—Г–ґ–љ–Њ –Њ—В–і–∞–≤–∞—В—М –Ї–Њ—А—А–µ–Ї—В–љ–Њ. –Э–∞–њ—А–Є–Љ–µ—А, –µ—Б–ї–Є –Њ—В–і–∞–≤–∞—В—М –Ї–Њ–і 200, —В–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї –њ—А–Њ–Є–љ–і–µ–Ї—Б–Є—А—Г–µ—В —В–∞–Ї—Г—О —Б—В—А–∞–љ–Є—Ж—Г, –љ–Њ –Њ–љ–∞ –±—Г–і–µ—В –љ–µ–Ї–∞—З–µ—Б—В–≤–µ–љ–љ–Њ–є –њ–Њ –Љ–љ–µ–љ–Є—О –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –Љ–∞—И–Є–љ—Л. –С–Њ–ї—М—И–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –љ–µ–Ї–∞—З–µ—Б—В–≤–µ–љ–љ—Л—Е —Б—В—А–∞–љ–Є—Ж –≤–µ–і–µ—В –Ї –љ–µ–і–Њ–≤–µ—А–Є—О –њ–Њ –Њ—В–љ–Њ—И–µ–љ–Є—О –Ї —Б–∞–є—В—Г –Є –њ–Њ–≤—Л—И–∞–µ—В –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М –њ–Њ–њ–∞–і–∞–љ–Є–µ –њ–Њ–і —Д–Є–ї—М—В—А, –њ–Њ—Б–ї–µ —З–µ–≥–Њ —Б–∞–є—В –љ–µ –±—Г–і–µ—В —Г—З–∞—Б—В–≤–Њ–≤–∞—В—М –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–µ.

–Ф—Г–±–ї–Є —Б—В—А–∞–љ–Є—Ж –љ–∞ —Б–∞–є—В–µ. –°—В—А–∞–љ–Є—Ж—Л —Б –Њ–і–Є–љ–∞–Ї–Њ–≤—Л–Љ —Б–Њ–і–µ—А–ґ–Є–Љ—Л–Љ, –љ–Њ —Б —А–∞–Ј–љ—Л–Љ–Є –∞–і—А–µ—Б–∞–Љ–Є —Б—В—А–∞–љ–Є—Ж –љ—Г–ґ–љ–Њ –Ј–∞–Ї—А—Л–≤–∞—В—М –Њ—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є –Љ–∞—И–Є–љ–∞–Љ–Є. –Я–Њ—Б–Ї–Њ–ї—М–Ї—Г —В–µ–Ї—Б—В –љ–∞ —В–∞–Ї–Є—Е —Б—В—А–∞–љ–Є—Ж–∞—Е –±—Г–і–µ—В —Б—З–Є—В–∞—В—М—Б—П –љ–µ—Г–љ–Є–Ї–∞–ї—М–љ—Л–Љ, –њ–Њ –Љ–љ–µ–љ–Є—О –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Њ–≤. –С–Њ–ї—М—И–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –љ–µ–Ї–∞—З–µ—Б—В–≤–µ–љ–љ—Л—Е —Б—В—А–∞–љ–Є—Ж (—Б —Г–љ–Є–Ї–∞–ї—М–љ–Њ—Б—В—М—О —В–µ–Ї—Б—В–∞ –Љ–µ–љ—М—И–µ 70%) –Љ–Њ–ґ–µ—В —В–∞–Ї –ґ–µ –њ—А–Є–≤–µ—Б—В–Є –Ї —Г–≤–µ–ї–Є—З–µ–љ–Є—О –љ–µ–і–Њ–≤–µ—А–Є—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –њ–Њ –Њ—В–љ–Њ—И–µ–љ–Є—О –Ї —Б–∞–є—В—Г.

–Э–∞–њ—А–Є–Љ–µ—А, –њ–Њ –Љ–љ–µ–љ–Є—О –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –і—Г–±–ї—П–Љ–Є —Б—В—А–∞–љ–Є—Ж —П–≤–ї—П—О—В—Б—П:

- http://shtepsel.com/category/perehodniki-dlya-canon/

- http://shtepsel.com/category/perehodniki-dlya-canon/?order=title

–Э–∞ –њ–µ—А–≤–Њ–є –Є–Ј –љ–Є—Е —В–Њ–≤–∞—А—Л —Г–њ–Њ—А—П–і–Њ—З–µ–љ—Л —А–µ–є—В–Є–љ–≥—Г, –∞ –љ–∞ –≤—В–Њ—А–Њ–є – –њ–Њ –∞–ї—Д–∞–≤–Є—В—Г.

–Ґ–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л –љ—Г–ґ–љ–Њ –Ј–∞–Ї—А—Л–≤–∞—В—М –Њ—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є —Б–Є—Б—В–µ–Љ–∞–Љ–Є. –°–і–µ–ї–∞—В—М —Н—В–Њ –Љ–Њ–ґ–љ–Њ –Њ–і–љ–Є–Љ –Є–Ј —В—А–µ—Е —Б–њ–Њ—Б–Њ–±–Њ–≤.

1) –Ч–∞–Ї—А—Л—В–Є–µ –і—Г–±–ї–µ–є —Б—В—А–∞–љ–Є—Ж –≤ —Д–∞–є–ї–µ robots.txt. –Я–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є —Г—З–Є—В—Л–≤–∞—О—В —Д–∞–є–ї, –Ї–Њ—В–Њ—А—Л–є –љ–∞–Ј—Л–≤–∞–µ—В—Б—П robots.txt –Є –љ–∞—Е–Њ–і–Є—В—М—Б—П –≤ –Ї–Њ—А–љ–µ —Б–∞–є—В–∞. –Э–∞–њ—А–Є–Љ–µ—А, –і–ї—П —Б–∞–є—В–∞ shtepsel.com –Њ–љ –і–Њ—Б—В—Г–њ–µ–љ –њ–Њ –∞–і—А–µ—Б—Г:

http://shtepsel.com/robots.txt

–Т –і–∞–љ–љ—Л–є —Д–∞–є–ї –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ –Ј–∞–љ–µ—Б—В–Є —Б–ї—Г–ґ–µ–±–љ—Г—О –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О –≤–Є–і:

User-agent: *

Disallow: /*/?order=*

–≠—В–Њ –і–∞—Б—В –Ј–љ–∞—В—М –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ —Б–Є—Б—В–µ–Љ–∞–Љ, —З—В–Њ —Б—В—А–∞–љ–Є—Ж—Л, —Б–Њ–і–µ—А–ґ–∞—Й–Є–µ –≤ —Б–≤–Њ–µ–Љ –∞–і—А–µ—Б–µ —Б—В—А–Њ–Ї—Г /?order= –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М –љ–µ —Б–ї–µ–і—Г–µ—В. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –Љ—Л –Є–Ј–±–∞–≤–Є–Љ—Б—П –Њ—В –і—Г–±–ї–µ–є.

2) –Ч–∞–Ї—А—Л—В–Є–µ –і—Г–±–ї–µ–є —Б—В—А–∞–љ–Є—Ж —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–Љ –Љ–µ—В–∞-—В–µ–≥–Њ–Љ –≤ html-–Ї–Њ–і–µ —Б—В—А–∞–љ–Є—Ж—Л. –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л —Г—З–Є—В—Л–≤–∞—О —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–є –Љ–µ—В–∞-—В–µ–≥, –Ї–Њ—В–Њ—А—Л–є —А–∞—Б–њ–Њ–ї–Њ–ґ–µ–љ –≤ –±–ї–Њ–Ї–µ <head> html-–Ї–Њ–і–∞ —Б—В—А–∞–љ–Є—Ж—Л. –Э–∞–њ—А–Є–Љ–µ—А,

<meta name="robots" content="noindex,follow">

–Ґ–∞–Ї–Њ–є —В–µ–≥ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –љ–µ –≤–Ї–ї—О—З–∞—В—М —Б—В—А–∞–љ–Є—Ж—Г –≤ –Є–љ–і–µ–Ї—Б –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л, –љ–Њ –њ—А–Є —Н—В–Њ–Љ —Г—З–Є—В—Л–≤–∞—В—М —Б—Б—Л–ї–Ї–Є —Б –љ–µ–µ.

<meta name="robots" content="noindex,nofollow">

–Ґ–∞–Ї–Њ–є —В–µ–≥ –њ–Њ–Ј–≤–Њ–ї—П–µ—В –љ–µ –≤–Ї–ї—О—З–∞—В—М —Б—В—А–∞–љ–Є—Ж—Г –≤ –Є–љ–і–µ–Ї—Б –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л –Є —В–∞–Ї –ґ–µ –љ–µ —Г—З–Є—В—Л–≤–∞—В—М —Б—Б—Л–ї–Ї–Є —Б –љ–µ–µ.

3) –£–Ї–∞–Ј–∞–љ–Є–µ –љ–∞ –Ї–∞–љ–Њ–љ–Є—З–µ—Б–Ї—Г—О —Б–Є—Б—В–µ–Љ—Г. –Х—Б–ї–Є –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ –≤—Б–µ –ґ–µ –Њ–±–љ–∞—А—Г–ґ–Є–≤–∞–µ—В –і—Г–±–ї—М —Б—В—А–∞–љ–Є—Ж—Л, –љ–µ –Ј–∞–Ї—А—Л—В—Л–є –Њ—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є, —В–Њ –Њ–љ–∞ –њ—А–Њ–±—Г–µ—В –Њ–њ—А–µ–і–µ–ї–Є—В—М –Ї–∞–љ–Њ–љ–Є—З–µ—Б–Ї—Г—О (–≥–ї–∞–≤–љ—Г—О) —Б—В—А–∞–љ–Є—Ж—Г, –Ї–Њ—В–Њ—А–∞—П –Є –±—Г–і–µ—В —Г—З–∞—Б—В–≤–Њ–≤–∞—В—М –≤ —А–µ–Ј—Г–ї—М—В–∞—В–∞—Е –њ–Њ–Є—Б–Ї–∞. –Э–µ –≤—Б–µ–≥–і–∞ –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ –≤—Л–±–Є—А–∞–µ—В –≥–ї–∞–≤–љ—Г—О —Б—В—А–∞–љ–Є—Ж—Г –і–Њ–ї–ґ–љ—Л–Љ –Њ–±—А–∞–Ј–Њ–Љ —В–∞–Ї, –Ї–∞–Ї —Н—В–Њ–≥–Њ —Е–Њ—З–µ—В –Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А. –Ь–Њ–ґ–љ–Њ —П–≤–љ–Њ –Њ–±–Њ–Ј–љ–∞—З–Є—В—М –∞–і—А–µ—Б –Ї–∞–љ–Њ–љ–Є—З–µ—Б–Ї–Њ–є —Б—В—А–∞–љ–Є—Ж—Л –≤ html-–Ї–Њ–і–µ —Б—В—А–∞–љ–Є—Ж—Л, —П–≤–ї—П—О—Й–µ–є—Б—П –і—Г–±–ї–µ–Љ.

–Э–∞–њ—А–Є–Љ–µ—А, –≤ –±–ї–Њ–Ї–µ <head> —Б—В—А–∞–љ–Є—Ж—Л

http://shtepsel.com/category/perehodniki-dlya-canon/?order=title

–Љ–Њ–ґ–љ–Њ —Г–Ї–∞–Ј–∞—В—М —В–µ–≥:

<link rel="canonical" href="http://shtepsel.com/category/perehodniki-dlya-canon/"/>

–Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –Љ–Њ–ґ–љ–Њ «–і–∞—В—М –Ј–љ–∞—В—М» –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї—Г, —З—В–Њ –і–∞–љ–љ–∞—П —Б—В—А–∞–љ–Є—Ж–∞ –љ–µ —П–≤–ї—П–µ—В—Б—П –≥–ї–∞–≤–љ–Њ–є –Є –µ–µ –љ–µ –љ—Г–ґ–љ–Њ –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М, –∞ –≥–ї–∞–≤–љ–Њ–є —П–≤–ї—П–µ—В—Б—П —Б—В—А–∞–љ–Є—Ж–∞:

http://shtepsel.com/category/perehodniki-dlya-canon/

–Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –Ј–∞–Ї—А—Л–≤–∞—В—М –Њ—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ —Б—В—А–∞–љ–Є—Ж—Л —Б –Љ–∞–ї—Л–Љ –Њ–±—К–µ–Љ–Њ–Љ –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є. –Э–∞–њ—А–Є–Љ–µ—А, —Б–њ—А–∞–≤–Њ—З–љ—Л–µ —Б—В—А–∞–љ–Є—Ж—Л —Б –Њ—З–µ–љ—М –Љ–∞–ї—Л–Љ –Њ–±—К–µ–Љ–Њ–Љ –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є (150 —Б–Є–Љ–≤–Њ–ї–Њ–≤ –Є –Љ–µ–љ—М—И–µ). –°—В—А–∞–љ–Є—Ж—Л –≥–∞–ї–µ—А–µ–Є —Д–Њ—В–Њ–≥—А–∞—Д–Є–є, –µ—Б–ї–Є —В–∞–Ї–Є—Е —Б—В—А–∞–љ–Є—Ж –љ–∞ —Б–∞–є—В–µ –Њ—З–µ–љ—М –Љ–љ–Њ–≥–Њ, —В–∞–Ї –ґ–µ –Љ–Њ–ґ–љ–Њ –Ј–∞–Ї—А—Л—В—М –Њ—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є. –°–ї—Г–ґ–µ–±–љ—Л–µ —Б—В—А–∞–љ–Є—Ж—Л, –љ–µ –Є–Љ–µ—О—Й–Є–µ –љ–Є–Ї–∞–Ї–Њ–є –≤–∞–ґ–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –Љ–∞—И–Є–љ—Л, –љ–∞–њ—А–Є–Љ–µ—А, –і–Њ–±–∞–≤–ї–µ–љ–Є–µ —В–Њ–≤–∞—А–∞ –≤ –Ї–Њ—А–Ј–Є–љ—Г. –Э–∞ –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б—В–∞—А—Л—Е –≤–µ—А—Б–Є—П—Е –і–≤–Є–ґ–Ї–Њ–≤ –і–ї—П —В–Њ–≥–Њ, —З—В–Њ–±—Л —Б–ї–µ–і–Є—В—М –Ј–∞ –і–µ–є—Б—В–≤–Є—П–Љ–Є –Ї–∞–ґ–і–Њ–≥–Њ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П, –њ—А–Є –Ї–∞–ґ–і–Њ–Љ –љ–Њ–≤–Њ–Љ –Њ–±—А–∞—Й–µ–љ–Є–Є –Ї —Б–∞–є—В—Г —Д–Њ—А–Љ–Є—А—Г–µ—В—Б—П –љ–Њ–≤–∞—П —Б–µ—Б—Б–Є—П, –Ї–Њ—В–Њ—А–∞—П –Њ–±–Њ–Ј–љ–∞—З–∞–µ—В—Б—П –њ–∞—А–∞–Љ–µ—В—А–Њ–Љ GET –њ—Г—В–µ–Љ –њ—А–Є—Б–≤–Њ–µ–љ–Є—П —Г–љ–Є–Ї–∞–ї—М–љ–Њ–≥–Њ –Ј–љ–∞—З–µ–љ–Є—П —Б–µ—Б—Б–Є–Є –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–є –њ–µ—А–µ–Љ–µ–љ–љ–Њ–є. –Э–∞–њ—А–Є–Љ–µ—А, –Ї –∞–і—А–µ—Б—Г —Б—В—А–∞–љ–Є—Ж—Л –Љ–Њ–ґ–µ—В –і–Њ–±–∞–≤–ї—П—В—М—Б—П –њ–∞—А–∞–Љ–µ—В—А g2_GALLERYSID=565423432423423423, –Ј–љ–∞—З–µ–љ–Є–µ –Ї–Њ—В–Њ—А–Њ–≥–Њ –±—Г–і–µ—В –Љ–µ–љ—П—В—М—Б—П –њ—А–Є –њ–Њ–≤—В–Њ—А–љ–Њ–Љ –Ј–∞—Е–Њ–і–µ –љ–∞ —Б–∞–є—В. –Ґ–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л –љ–Є –≤ –Ї–Њ–µ–Љ —Б–ї—Г—З–∞–µ –љ–µ –і–Њ–ї–ґ–љ—Л –њ–Њ–њ–∞–і–∞—В—М –≤ –Є–љ–і–µ–Ї—Б –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л, –њ–Њ—Б–Ї–Њ–ї—М–Ї—Г –њ—А–Є –Ї–∞–ґ–і–Њ–Љ –Њ–±—А–∞—Й–µ–љ–Є–Є –Ї —Б–∞–є—В—Г, –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ –±—Г–і–µ—В –њ–Њ–ї—Г—З–∞—В—М –љ–Њ–≤—Л–µ —Б—В—А–∞–љ–Є—Ж—Л –Є –љ–Є–Ї–Њ–≥–і–∞ –љ–µ —Б–Љ–Њ–ґ–µ—В –њ—А–Њ–Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М –≤–µ—Б—М —Б–∞–є—В. –Х—Й–µ –љ—Г–ґ–љ–Њ –Ј–∞–Ї—А—Л–≤–∞—В—М —Б—В—А–∞–љ–Є—Ж—Л —Б –љ–µ —Г–љ–Є–Ї–∞–ї—М–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–µ–є, —Б–Ї–Њ–њ–Є—А–Њ–≤–∞–љ–љ–Њ–є —Б –і—А—Г–≥–Є—Е —Б–∞–є—В–Њ–≤. –†–∞–Ј—А–µ—И–∞—В—М –Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М —В–∞–Ї–Є–µ –љ–µ —Г–љ–Є–Ї–∞–ї—М–љ—Л —Б—В—А–∞–љ–Є—Ж—Л, –µ—Б–ї–Є, –Ї–Њ–љ–µ—З–љ–Њ, –Њ–љ–Є –Є–Љ–µ—О—В—Б—П, –љ–µ–ї—М–Ј—П. –Я–Њ—Б–Ї–Њ–ї—М–Ї—Г —Н—В–Њ –Љ–Њ–ґ–µ—В –њ—А–Є–≤–µ—Б—В–Є –љ–µ–і–Њ–≤–µ—А–Є—О –Є –і–∞–ґ–µ –±–∞–љ—Г —Б–∞–є—В–∞ –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ–µ.

–І–µ–ї–Њ–≤–µ–Ї–Њ-–њ–Њ–љ—П—В–љ—Л–µ URL (–І–Я–£).

–Я—А–Є —Б–Њ–Ј–і–∞–љ–Є–Є –і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–Є—Е —Б–∞–є—В–Њ–≤ —З–∞—Б—В–Њ –≤—Б–µ–Љ —Б–∞–є—В–Њ–≤ —Г–њ—А–∞–≤–ї—П–µ—В –Њ–і–Є–љ –Є–љ–і–µ–Ї—Б–љ—Л–є —Д–∞–є–ї, –Ї–Њ—В–Њ—А—Л–є –љ–∞—Е–Њ–і–Є—В—М—Б—П –≤ –Ї–Њ—А–љ–µ —Б–∞–є—В–∞ –Є –Њ–±—Л—З–љ–Њ –љ–∞–Ј—Л–≤–∞–µ—В—Б—П index.php.

–Т —В–∞–Ї–Њ–Љ —Б–ї—Г—З–∞–µ –Њ–±—А–∞—Й–µ–љ–Є–µ –Ї –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–є —Б—В—А–∞–љ–Є—Ж–µ —Б–∞–є—В–∞ –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В—М—Б—П –њ—Г—В–µ–Љ –њ–µ—А–µ–і–∞—З–Є –љ–µ–Њ–±—Е–Њ–і–Є–Љ—Л—Е –њ–∞—А–∞–Љ–µ—В—А–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ –њ–Є—И—Г—В—Б—П –њ–Њ—Б–ї–µ —Б–ї—Г–ґ–µ–±–љ–Њ–≥–Њ —Б–Є–Љ–≤–Њ–ї–∞ ? –Є —А–∞–Ј–і–µ–ї—П—О—В—Б—П –і—А—Г–≥–Є–Љ —Б–ї—Г–ґ–µ–±–љ—Л–Љ —Б–Є–Љ–≤–Њ–ї–Њ–Љ: &, –љ–∞–њ—А–Є–Љ–µ—А:

http://shtepsel.com/index.php?choice=good&action=goodList&category_id=223

–њ–µ—А–µ–і–∞—О—В—Б—П –њ–∞—А–∞–Љ–µ—В—А—Л choice=good, action=goodList –Є category_id=223.

–Я–∞—А–∞–Љ–µ—В—А—Л –і–∞—О—В –њ–Њ–љ—П—В—М –і–≤–Є–ґ–Ї—Г —З—В–Њ –љ—Г–ґ–љ–Њ –Њ—В–Њ–±—А–∞–Ј–Є—В—М –љ–∞ —Б—В—А–∞–љ–Є—Ж–µ – –Ї–∞—В–µ–≥–Њ—А–Є—О —В–Њ–≤–∞—А–Њ–≤ –Є–ї–Є —Б–∞–Љ —В–Њ–≤–∞—А, –∞ —В–∞–Ї –ґ–µ –µ—Б–ї–Є –Ї–∞—В–µ–≥–Њ—А–Є—О, —В–Њ –Ї–∞–Ї—Г—О, –µ—Б–ї–Є —Б–∞–Љ —В–Њ–≤–∞—А, —В–Њ –Ї–∞–Ї–Њ–є.

–Ґ–∞–Ї–Є–µ –∞–і—А–µ—Б–∞ –љ–µ –Њ—З–µ–љ—М —Г–і–Њ–±–љ—Л —Б —В–Њ—З–Ї–Є –Ј—А–µ–љ–Є—П –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П. –Я–Њ—Н—В–Њ–Љ—Г —Б–µ–є—З–∞—Б —З–∞—Й–µ –њ—Г—В–µ–Љ –љ–µ—Б–ї–Њ–ґ–љ—Л—Е –љ–∞—Б—В—А–Њ–µ–Ї, –њ–µ—А–µ–≤–Њ–і—П—В —А–∞–±–Њ—В—Г –ї—О–±–Њ–≥–Њ –і–≤–Є–ґ–Ї–∞ –љ–∞ –і—А—Г–≥–Є–µ –∞–і—А–µ—Б–∞, –±–Њ–ї–µ–µ –њ–Њ–љ—П—В–љ—Л–µ –і–ї—П –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П, –љ–∞–њ—А–Є–Љ–µ—А:

http://shtepsel.com/category/povyshayushchie-perehodnye-kolca/

–Ґ–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л –Љ–Њ–ґ–µ—В –Њ–±—А–∞–±–∞—В—Л–≤–∞—В—М –≤—Б–µ —В–Њ—В –ґ–µ –Є–љ–і–µ–Ї—Б–љ—Л–є —Д–∞–є–ї, «–њ–Њ–љ–Є–Љ–∞—П» —З—В–Њ –Є–Љ–µ–љ–љ–Њ –љ—Г–ґ–љ–Њ –Њ—В–Њ–±—А–∞–Ј–Є—В—М –Є –Ї–∞–Ї–Њ–є id –њ—А–Є —Н—В–Њ–Љ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М. –°–Њ–Њ—В–≤–µ—В—Б—В–≤–Є—П —Н—В–Є—Е id –Є –∞–і—А–µ—Б–Њ–≤ —Б—В—А–∞–љ–Є—Ж –њ—А–Є —Н—В–Њ–Љ —Е—А–∞–љ—П—В—Б—П –≤ –±–∞–Ј–µ –і–∞–љ–љ—Л—Е.

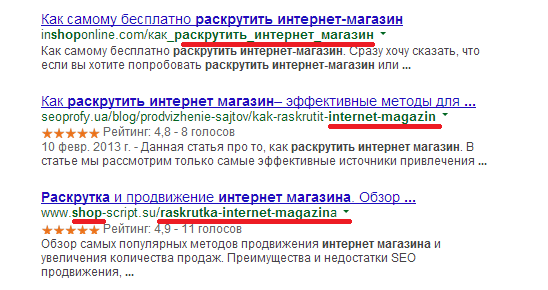

–Ґ–∞–Ї–Є–µ –∞–і—А–µ—Б–∞ –љ–∞–Ј—Л–≤–∞—О—В —З–µ–ї–Њ–≤–µ–Ї–Њ-–њ–Њ–љ—П—В–љ—Л–Љ–Є. –Ш—Е –±–Њ–ї—М—И–µ «–ї—О–±—П—В» –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –≤ –Њ—В–ї–Є—З–Є–µ –Њ—В –і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–Є—Е –∞–і—А–µ—Б–Њ–≤. –Ъ—А–Њ–Љ–µ —В–Њ–≥–Њ, –Ї–ї—О—З–µ–≤—Л–µ —Б–ї–Њ–≤–∞, –Ї–Њ—В–Њ—А—Л–µ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –≤ —Д–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є–Є –∞–і—А–µ—Б–Њ–≤ —Б—В—А–∞–љ–Є—Ж —Г—З–Є—В—Л–≤–∞—О—В—Б—П –њ—А–Є —А–∞–љ–ґ–Є—А–Њ–≤–∞–љ–Є–Є —Б–∞–є—В–Њ–≤ (—Б–Љ. –њ–Њ–і—З–µ—А–Ї–љ—Г—В—Л–µ –Ї—А–∞—Б–љ—Л–Љ —Б–ї–Њ–≤–∞ –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–µ –љ–∞ –њ—А–Є–Љ–µ—А–µ, –њ–Њ–Ї–∞–Ј–∞–љ–љ–Њ–Љ –љ–∞ —А–Є—Б—Г–љ–Ї–µ ). –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –і–∞–ґ–µ –≤—Л–і–µ–ї—П—О—В —В–∞–Ї–Є–µ —Б–ї–Њ–≤–∞ –ґ–Є—А–љ—Л–Љ.

–Ъ–∞—А—В–∞ —Б–∞–є—В–∞. –Э–µ–Љ–∞–ї–Њ–≤–∞–ґ–љ–Њ–є —П–≤–ї—П–µ—В—Б—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М —Г–Ї–∞–Ј–∞—В—М –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї—Г —Б—А–∞–Ј—Г –≤—Б–µ —Б—В—А–∞–љ–Є—Ж—Л —Б–∞–є—В–∞. –Ґ–∞–Ї –µ–Љ—Г «–ї–µ–≥—З–µ» –њ—А–Њ–Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М —Б–∞–є—В. –Ґ–∞–Ї–∞—П –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –µ—Б—В—М –≤–Њ –Љ–љ–Њ–≥–Є—Е –і–≤–Є–ґ–Ї–∞. –Ю–±—Л—З–љ–Њ –Ї–∞—А—В–∞ —Б–∞–є—В–∞ —Д–Њ—А–Љ–Є—А—Г–µ—В—Б—П –≤ xml-—Д–Њ—А–Љ–∞—В–µ, –Ї–Њ—В–Њ—А—Л–є –њ—А–µ–Ї—А–∞—Б–љ–Њ –њ–Њ–љ–Є–Љ–∞—О—В –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є. –Ґ–∞–Ї –ґ–µ –µ—Б—В—М —Б—В–Њ—А–Њ–љ–љ–Є–µ —Б–µ—А–≤–Є—Б—Л, –Ї–Њ—В–Њ—А—Л–µ –њ–Њ–Ј–≤–Њ–ї—П—О—В –њ—А–Њ—Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М —Б–∞–є—В –Є —Б—Д–Њ—А–Љ–Є—А–Њ–≤–∞—В—М –Ї–∞—А—В—Г —Б–∞–є—В–∞ –≤ —Д–Њ—А–Љ–∞—В–µ xml. –Т –њ–∞–љ–µ–ї–Є –≤–µ–±–Љ–∞—Б—В–µ—А–∞ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е –Љ–∞—И–Є–љ –Љ–Њ–ґ–љ–Њ —Г–Ї–∞–Ј–∞—В—М –љ–∞ –Ї–∞—А—В—Г —Б–∞–є—В–∞.

- –Ф–ї—П –Ї–Њ–Љ–Љ–µ–љ—В–Є—А–Њ–≤–∞–љ–Є—П –≤–Њ–є–і–Є—В–µ –Є–ї–Є –Ј–∞—А–µ–≥–Є—Б—В—А–Є—А—Г–є—В–µ—Б—М