–Ъ–∞–Ї —А–∞–±–Њ—В–∞—О—В –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л

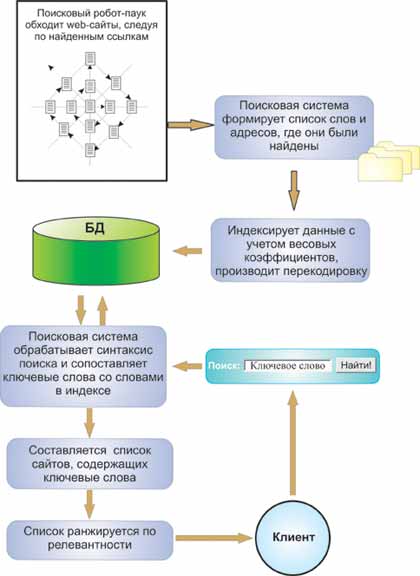

–Я–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ – —Н—В–Њ –Њ–≥—А–Њ–Љ–љ—Л–є –Ї–Њ–Љ–њ–ї–µ–Ї—Б, —Б–Њ—Б—В–Њ—П—Й–Є–є –Є–Ј –Њ–±–Њ—А—Г–і–Њ–≤–∞–љ–Є—П, –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–љ–Њ–≥–Њ –і–ї—П –≤—Л—З–Є—Б–ї–µ–љ–Є–є, —Е—А–∞–љ–µ–љ–Є—П –і–∞–љ–љ—Л—Е, –∞ —В–∞–Ї –ґ–µ –Є–Ј –њ—А–Њ–≥—А–∞–Љ–Љ–љ–Њ–≥–Њ –Њ–±–µ—Б–њ–µ—З–µ–љ–Є—П, –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–љ–Њ–≥–Њ –і–ї—П —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є—П —Б–∞–є—В–Њ–≤ –≤ –Є–љ—В–µ—А–љ–µ—В–µ (—Б–њ–µ—Ж–Є–∞–ї—М–љ–Њ–є –њ—А–Њ–≥—А–∞–Љ–Љ–Њ–є – —Б–Ї–∞–љ–µ—А–Њ–Љ-–њ–∞—Г–Ї–Њ–Љ).

–І—В–Њ –њ–Њ–љ–Є–Љ–∞–µ—В—Б—П –њ–Њ–і —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є–µ–Љ —Б–∞–є—В–∞? –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л —Б–Њ–±–Є—А–∞—О—В –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О —Б–Њ –≤—Б–µ—Е —Б—В—А–∞–љ–Є—Ж —Б–∞–є—В–Њ–≤ –њ—Г—В–µ–Љ —Б–Ї–∞—З–Є–≤–∞–љ–Є—П —Б—В—А–∞–љ–Є—Ж –≤ —Б–≤–Њ–Є –±–∞–Ј—Л –і–∞–љ–љ—Л—Е –і–ї—П –і–∞–ї—М–љ–µ–є—И–µ–є –Њ–±—А–∞–±–Њ—В–Ї–Є –Є —Г—З–µ—В–∞ –≤ —Д–Њ—А–Љ–Є—А–Њ–≤–∞–љ–Є–Є –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–Є. –≠—В–Њ –њ—А–Є–Љ–µ—А–љ–Њ –Ї–∞–Ї —З–µ–ї–Њ–≤–µ–Ї «—Б–Ї–∞–љ–Є—А—Г–µ—В» –њ–µ—А–µ—Е–Њ–і—П —Б –Њ–і–љ–Њ–є —Б—В—А–∞–љ–Є—Ж—Л –љ–∞ –і—А—Г–≥—Г—О –≤ –њ–Њ–Є—Б–Ї–∞—Е –љ—Г–ґ–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є, —В–Њ–ї—М–Ї–Њ –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ (–Я–°) –і–µ–ї–∞–µ—В —Н—В–Њ –≤ –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –Љ–Є–ї–ї–Є–∞—А–і–Њ–≤ —А–∞–Ј –±—Л—Б—В—А–µ–µ.

–†–Њ–ї—М –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л. –Я–Њ—Б–Ї–Њ–ї—М–Ї—Г –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –Љ–Њ–≥—Г—В —Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М –Є –Њ–±—А–∞–±–∞—В—Л–≤–∞—В—М –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О –≤ –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ –Љ–Є–ї–ї–Є–∞—А–і–Њ–≤ —А–∞–Ј –±—Л—Б—В—А–µ–µ, —З–µ–Љ —З–µ–ї–Њ–≤–µ–Ї, —А–Њ–ї—М –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –Ї–∞–Ї —А–∞–Ј –Є —Б–Њ—Б—В–Њ–Є—В –≤ —Б–Є—Б—В–µ–Љ–∞—В–Є–Ј–∞—Ж–Є–Є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є –Є –њ—А–µ–і–Њ—Б—В–∞–≤–ї–µ–љ–Є—О –µ–µ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П–Љ –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –Є—Е –њ–Њ—В—А–µ–±–љ–Њ—Б—В–µ–є. –°–≤–Њ–Є –њ–Њ—В—А–µ–±–љ–Њ—Б—В–Є –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–Є –≤—Л—А–∞–ґ–∞—О—В –≤ –≤–Є–і–µ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Д—А–∞–Ј—Л (–Є–ї–Є –µ—Й–µ –љ–∞–Ј—Л–≤–∞—О—В –њ–Њ–Є—Б–Ї–Њ–≤—Л–є –Ј–∞–њ—А–Њ—Б, –Ї–ї—О—З, –Ї–µ–є, –Ї–ї—О—З–µ–≤–∞—П —Д—А–∞–Ј–∞). –Я–Њ—Н—В–Њ–Љ—Г –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї—Г –і–ї—П –≤—Л–њ–Њ–ї–љ–µ–љ–Є—П —Б–≤–Њ–µ–є —А–Њ–ї–Є –љ—Г–ґ–љ–Њ –њ—А–∞–≤–Є–ї—М–љ–Њ —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М –њ–Њ—В—А–µ–±–љ–Њ—Б—В–Є —З–µ–ї–Њ–≤–µ–Ї–∞ –њ–Њ –µ–≥–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Д—А–∞–Ј–µ.

–°—Е–µ–Љ–∞ —Г—Б—В—А–Њ–є—Б—В–≤–∞ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л

–Я–Њ–Є—Б–Ї–Њ–≤—Г—О —Б–Є—Б—В–µ–Љ—Г –Љ–Њ–ґ–љ–Њ —Б—А–∞–≤–љ–Є—В—М —Б –±–Є–±–ї–Є–Њ—В–µ—З–љ—Л–Љ –Ї–∞—В–∞–ї–Њ–≥–Њ–Љ. –Ю–і–љ–∞–Ї–Њ –±–Є–±–ї–Є–Њ—В–µ—З–љ—Л–є –Ї–∞—В–∞–ї–Њ–≥ —Б–Њ–і–µ—А–ґ–Є—В –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О, —Б–Њ—Б—В–∞–≤–ї–µ–љ–љ—Г—О –Є–Ј –Ч–∞–≥–Њ–ї–Њ–≤–Ї–Њ–≤ –Ї–љ–Є–≥, –Є—Е –∞–≤—В–Њ—А–Њ–≤ –Є –љ–Њ–Љ–µ—А–∞ –Ї–љ–Є–ґ–љ–Њ–≥–Њ –Є–Ј–і–∞–љ–Є—П ISBN (–∞–љ–≥–ї. International Standard Book Number, —А—Г—Б. –Ь–µ–ґ–і—Г–љ–∞—А–Њ–і–љ—Л–є —Б—В–∞–љ–і–∞—А—В–љ—Л–є –Ї–љ–Є–ґ–љ—Л–є –љ–Њ–Љ–µ—А). –Ч–∞ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–µ –ґ–µ –љ–Њ–Љ–µ—А–∞ ISBN –љ–µ—Б—Г—В –Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ—Б—В—М —А–µ–і–∞–Ї—Ж–Є–Є, –≤ –Ї–Њ—В–Њ—А—Л—Е —В–Є—А–∞–ґ–Є—А—Г—О—В—Б—П –Ї–љ–Є–ґ–љ—Л–µ –Є–Ј–і–∞–љ–Є—П. –Р –≤ —Б–ї—Г—З–∞–µ –Ш–љ—В–µ—А–љ–µ—В-—Б–∞–є—В–Њ–≤, –Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ—Б—В—М –Ј–∞ –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О –≤ –Ј–∞–≥–Њ–ї–Њ–≤–Ї–∞—Е —Б—В—А–∞–љ–Є—Ж –Є —Б–∞–є—В–Њ–≤ –љ–µ—Б—Г—В —Б–∞–Љ–Є –∞–≤—В–Њ—А—Л —Б–∞–є—В–Њ–≤. –Я–Њ—Н—В–Њ–Љ—Г –≤ –і–∞–љ–љ–Њ–Љ —Б–ї—Г—З–∞–µ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ–µ –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ —Б–∞–Љ–Њ–є –Ї–Њ–љ—В—А–Њ–ї–Є—А–Њ–≤–∞—В—М —Н—В–Њ—В –њ—А–Њ—Ж–µ—Б—Б. –Т —Б–≤—П–Ј–Є —Б —Н—В–Є–Љ, –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ —Б–Є—Б—В–µ–Љ–∞–Љ –њ—А–Є—Е–Њ–і–Є—В—Б—П –љ–µ —В–Њ–ї—М–Ї–Њ —Г—З–Є—В—Л–≤–∞—В—М –Ј–∞–≥–Њ–ї–Њ–≤–Ї–Є —Б—В—А–∞–љ–Є—Ж, –љ–Њ –Є –Є —Б–∞–Љ—Г –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—О –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–љ—Г—О –љ–∞ –≤—Б–µ—Е —Б—В—А–∞–љ–Є—Ж–∞—Е –≤ –Є–љ—В–µ—А–љ–µ—В–µ. –Ш –≤ —Б–ї—Г—З–∞–µ –љ–∞—А—Г—И–µ–љ–Є—П –њ—А–∞–≤–Є–ї –њ—А–µ–і–Њ—Б—В–∞–≤–ї–µ–љ–Є—П –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є, —Д–Є–ї—М—В—А–Њ–≤–∞—В—М —В–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л.

–Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, –Љ–Њ–ґ–µ–Љ –њ–µ—А–µ–є—В–Є –Ї –Њ–њ—А–µ–і–µ–ї–µ–љ–Є—О —Ж–µ–ї–Є –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л. –¶–µ–ї—М –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л –Ј–∞–Ї–ї—О—З–∞–µ—В—Б—П –≤ –њ—А–µ–і–Њ—Б—В–∞–≤–ї–µ–љ–Є–Є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—О –њ–Њ –µ–≥–Њ –Ј–∞–њ—А–Њ—Б—Г, –Ї–Њ—В–Њ—А–∞—П —Г–і–Њ–≤–ї–µ—В–≤–Њ—А–Є—В –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П.

–Ъ–∞–Ї –Љ—Л —Г–ґ–µ –Њ–њ—А–µ–і–µ–ї–Є–ї–Є—Б—М –≤—Л—И–µ, —Ж–µ–ї—М –Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А–∞ —Б–∞–є—В–∞ –Ј–∞–Ї–ї—О—З–∞–µ—В—Б—П –≤ —В–Њ–Љ, —З—В–Њ –Њ–љ –њ–Њ–≤–ї–Є—П–µ—В –љ–∞ –њ–Њ–Є—Б–Ї–Њ–≤—Г—О –≤—Л–і–∞—З—Г —В–∞–Ї, —З—В–Њ –µ–≥–Њ —Б–∞–є—В –Њ–Ї–∞–ґ–µ—В—Б—П –≤—Л—И–µ –і—А—Г–≥–Є—Е. –Т —В–∞–Ї–Њ–Љ —Б–ї—Г—З–∞–µ, –µ—Б–ї–Є —Б—В—А–∞–љ–Є—Ж–∞, –Ї–Њ—В–Њ—А—Г—О –Њ–љ –њ—А–Њ–і–≤–Є–≥–∞–µ—В, —Г–і–Њ–≤–ї–µ—В–≤–Њ—А–Є—В –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П, —В–Њ —Ж–µ–ї–Є –Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А–∞ –Є –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л —Б–Њ–≤–њ–∞–і—Г—В (—В–∞–Ї–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П —Б–∞–є—В–Њ–≤ –љ–∞–Ј—Л–≤–∞–µ—В—Б—П – –±–µ–ї–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П). –Р –µ—Б–ї–Є —Б—В—А–∞–љ–Є—Ж–∞, –Ї–Њ—В–Њ—А—Г—О –Њ–љ –њ—А–Њ–і–≤–Є–≥–∞–µ—В, –Э–Х —Г–і–Њ–≤–ї–µ—В–≤–Њ—А–Є—В –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П, —В–Њ —Ж–µ–ї–Є –Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А–∞ –Є –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л –Э–Х —Б–Њ–≤–њ–∞–і—Г—В (—В–∞–Ї–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П —Б–∞–є—В–Њ–≤ –љ–∞–Ј—Л–≤–∞–µ—В—Б—П – —З–µ—А–љ–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П).

–Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –Ї—А–Њ–Љ–µ —Ж–µ–ї–Є —Г–і–Њ–≤–ї–µ—В–≤–Њ—А–Є—В—М –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є, –Є–Љ–µ–µ—В –Є —Д–Є–љ–∞–љ—Б–Њ–≤—Г—О —Ж–µ–ї—М, –њ–Њ—Б–Ї–Њ–ї—М–Ї—Г —П–≤–ї—П—О—В—Б—П –Ї–Њ–Љ–Љ–µ—А—З–µ—Б–Ї–Є–Љ–Є –Њ—А–≥–∞–љ–Є–Ј–∞—Ж–Є—П–Љ–Є –Є –Њ–±—П–Ј–∞–љ—Л –Ј–∞—А–∞–±–∞—В—Л–≤–∞—В—М –і–µ–љ—М–≥–Є –≤ —А–µ–Ј—Г–ї—М—В–∞—В–∞—Е —Б–≤–Њ–µ–є –і–µ—П—В–µ–ї—М–љ–Њ—Б—В–Є. –Я–Њ—Н—В–Њ–Љ—Г –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –≤—Б–µ–≥–і–∞ –±–Њ—А–Њ–ї–Є—Б—М, –±–Њ—А—О—В—Б—П –Є –±—Г–і—Г—В –±–Њ—А–Њ—В—М—Б—П —Б —З–µ—А–љ—Л–Љ–Є –Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А–∞–Љ–Є, –Ї–Њ—В–Њ—А—Л–µ, –њ–Њ —Б—Г—В–Є, —П–≤–ї—П—О—В—Б—П –њ—А–µ—В–µ–љ–і–µ–љ—В–∞–Љ–Є –љ–∞ —З–∞—Б—В—М –і–Њ—Е–Њ–і–∞ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ. –Я—А–Њ–і–≤–Є–≥–∞—П —Б–≤–Њ–є —Б–∞–є—В —Б–∞–Љ–Њ—Б—В–Њ—П—В–µ–ї—М–љ–Њ –љ—Г–ґ–љ–Њ –њ–Њ–Љ–љ–Є—В—М, —З—В–Њ –Ј–∞–љ–Є–Љ–∞—В—М—Б—П —З–µ—А–љ–Њ–є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–µ–є –≤—Б–µ–≥–і–∞ —П–≤–ї—П–µ—В—Б—П –±–Њ–ї—М—И–Є–Љ —А–Є—Б–Ї–Њ–Љ –љ–µ –і–Њ—Б—В–Є—З—М —А–µ–Ј—Г–ї—М—В–∞—В–∞, –њ–Њ—Б–Ї–Њ–ї—М–Ї—Г –ї—О–±—Л–µ –Љ–µ—В–Њ–і—Л —З–µ—А–љ–Њ–є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —А–∞–љ–Њ –Є–ї–Є –њ–Њ–Ј–і–љ–Њ —А–∞—Б–њ–Њ–Ј–љ–∞—О—В—Б—П –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞–Љ–Є.

–Ъ–∞–Ї –ґ–µ –≤–ї–Є—П—В—М –љ–∞ –≤—Л–і–∞—З—Г –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –ѓ–љ–і–µ–Ї—Б –Є Google –њ—А–Є —Б–µ–Њ-–Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є —Б–∞–є—В–∞? –Ф–ї—П —Н—В–Њ–≥–Њ, –љ—Г–ґ–љ–Њ –њ–Њ–љ–Є–Љ–∞—В—М –Ї–∞–Ї–Є–µ —Д–∞–Ї—В–Њ—А—Л –≤–ї–Є—П—О—В –љ–∞ –њ–Њ–Ј–Є—Ж–Є–Є —Б–∞–є—В–∞ –њ–Њ —В–Њ–Љ—Г –ї–Є–±–Њ –Є–љ–Њ–Љ—Г –Ј–∞–њ—А–Њ—Б—Г. –Э—Г–ґ–љ–Њ –љ–∞—З–∞—В—М —Б —В–Њ–≥–Њ —З—В–Њ –њ–Њ –Ї–∞–ґ–і–Њ–Љ—Г –Ј–∞–њ—А–Њ—Б—Г –≤ –≤—Л–і–∞—З–Є –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ–µ —Г—З–∞—Б—В–≤—Г–µ—В –≤—Б–µ–≥–Њ –Њ–і–љ–∞ —Б—В—А–∞–љ–Є—Ж–∞ —Б–∞–є—В–∞ (–Ј–∞ —А–µ–і–Ї–Є–Љ –Є—Б–Ї–ї—О—З–µ–љ–Є–µ–Љ –≤ –≤—Л–і–∞—З–µ –Љ–Њ–ґ–µ—В –њ—А–Є—Б—Г—В—Б—В–≤–Њ–≤–∞—В—М 2 –ї–Є–±–Њ 3 —Б—В—А–∞–љ–Є—Ж—Л). –Я–Њ—Н—В–Њ–Љ—Г —А–∞—Б–Ї—А—Г—З–Є–≤–∞—П —Б–≤–Њ–є —Б–Њ–±—Б—В–≤–µ–љ–љ—Л–є —Б–∞–є—В –≤ –ѓ–љ–і–µ–Ї—Б –ї–Є–±–Њ Google, –љ—Г–ґ–љ–Њ –њ–ї–∞–љ–Є—А–Њ–≤–∞—В—М –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ –њ–Њ –Ї–∞–ґ–і–Њ–Љ—Г –Ї–ї—О—З–µ–≤–Њ–Љ—Г —Б–ї–Њ–≤—Г –і–ї—П –Њ—В–і–µ–ї—М–љ–Њ —Б—В—А–∞–љ–Є—Ж—Л —Б–≤–Њ–µ–≥–Њ —Б–∞–є—В–∞. –≠—В–Њ—В –њ—А–Њ—Ж–µ—Б—Б –љ–∞–Ј—Л–≤–∞–µ—В—Б—П: —Б–Њ—Б—В–∞–≤–ї–µ–љ–Є–µ —Б–µ–Љ–∞–љ—В–Є—З–µ—Б–Ї–Њ–≥–Њ —П–і—А–∞ —Б–∞–є—В–∞ –Є —А–∞—Б–њ—А–µ–і–µ–ї–µ–љ–Є–µ –Ї–ї—О—З–µ–≤—Л—Е –Ј–∞–њ—А–Њ—Б–Њ–≤ –њ–Њ —Б—В—А–∞–љ–Є—Ж–∞–Љ —Б–∞–є—В–∞. –Ь—Л –њ–µ—А–µ–є–і–µ–Љ –Ї –љ–µ–Љ—Г –њ–Њ–Ј–ґ–µ, –≤ —Б–ї–µ–і—Г—О—Й–µ–Љ –Љ–Њ–і—Г–ї–µ, –∞ –њ–Њ–Ї–∞ –і–≤–Є–љ–µ–Љ—Б—П –і–∞–ї—М—И–µ.

–Т –≤—Л–і–∞—З–µ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –њ—А–Є–љ–Є–Љ–∞–µ—В —Г—З–∞—Б—В–Є–µ –њ–Њ –Њ–і–љ–Њ–є —Б—В—А–∞–љ–Є—Ж—Л —Б –Ї–∞–ґ–і–Њ–≥–Њ —Б–∞–є—В–∞ (—В–∞–Ї–Є–µ —Б—В—А–∞–љ–Є—Ж—Л —Б—З–Є—В–∞—О—В—Б—П —Ж–µ–ї–µ–≤—Л–Љ–Є –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Д—А–∞–Ј—Л)

–Т –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б–ї—Г—З–∞—П—Е –≤ —А–µ–Ј—Г–ї—М—В–∞—В–∞—Е –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–Є –Љ–Њ–ґ–µ—В –Њ—В–Њ–±—А–∞–ґ–∞—В—М—Б—П –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ —Б—В—А–∞–љ–Є—Ж –Њ–і–љ–Њ–≥–Њ —Б–∞–є—В–∞

–Ч–∞–Љ–µ—В–Є–Љ —З—В–Њ, –љ–µ —Б–Љ–Њ—В—А—П –љ–∞ —В–Њ, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л, —Б–Ї–∞–љ–Є—А—Г—О—В –Љ–Є–ї–ї–Є–∞—А–і—Л –љ–Њ–≤—Л—Е —Б—В—А–∞–љ–Є—Ж –≤ —Б—Г—В–Ї–Є, –≤—Л–і–∞—З–∞ –њ–Њ –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–Љ—Г –Ј–∞–њ—А–Њ—Б—Г –Є–Ј–Љ–µ–љ—П–µ—В—Б—П –љ–µ —В–∞–Ї —З–∞—Б—В–Њ. –≠—В–Њ —Б–≤—П–Ј–∞–љ–љ–Њ —Б –Ї–Њ–ї–Њ—Б—Б–∞–ї—М–љ—Л–Љ–Є –Ј–∞—В—А–∞—В–∞–Љ–Є —А–µ—Б—Г—А—Б–Њ–≤ –љ–∞ –Њ–±—А–∞–±–Њ—В–Ї—Г –і–∞–љ–љ—Л—Е. –Я–Њ–Є—Б–Ї–Њ–≤–∞—П –≤—Л–і–∞—З–∞ Google –Њ–±–љ–Њ–≤–ї—П–µ—В—Б—П –Њ–і–Є–љ —А–∞–Ј –≤ 1–2 –і–љ—П, –∞ –ѓ–љ–і–µ–Ї—Б–∞ – –Њ–і–Є–љ —А–∞–Ј –≤ 5-9 –і–љ–µ–є. –Ґ–∞–Ї–Є–µ –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –≤—Л–і–∞—З–Є —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –њ–Њ–Є—Б–Ї–∞ –њ–Њ –Ї–ї—О—З–µ–≤–Њ–Љ—Г —Б–ї–Њ–≤—Г –љ–∞–Ј—Л–≤–∞—О—В –Р–Я –≤—Л–і–∞—З–Є.

–Ф–ї—П —Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤–Њ–≤–∞–љ–Є—П —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤ –њ–Њ–Є—Б–Ї–∞ –≤ –Ї–Њ–Љ–њ–∞–љ–Є—П—Е, —А–∞–Ј—А–∞–±–Њ—В–∞–≤—И–Є—Е

–њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л —А–∞–±–Њ—В–∞–µ—В —И—В–∞—В –њ—А–Њ–≥—А–∞–Љ–Љ–Є—Б—В–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ –њ–Њ—Б—В–Њ—П–љ–љ–Њ —Г—Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤—Г—О—В —А–∞–±–Њ—В—Г –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ, –і–µ–ї–∞—П –Є—Е –±–Њ–ї–µ–µ —Б–Њ–≤–µ—А—И–µ–љ–љ—Л–Љ–Є. –Ю—Б–љ–Њ–≤–љ–∞—П —Ж–µ–ї—М —В–∞–Ї–Є—Е –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤ – –њ—А–∞–≤–Є–ї—М–љ–Њ –Њ—В—Б–Њ—А—В–Є—А–Њ–≤–∞—В—М —Б—В—А–∞–љ–Є—Ж—Л —Б–∞–є—В–Њ–≤ –≤ —А–µ–Ј—Г–ї—М—В–∞—В–∞—Е –≤—Л–і–∞—З–Є –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞ (—В–∞–Ї–Њ–µ –і–µ–є—Б—В–≤–Є–µ –љ–∞–Ј—Л–≤–∞—О—В – —А–∞–љ–ґ–Є—А–Њ–≤–∞–љ–Є–µ).

–Э–∞ —Б–µ–≥–Њ–і–љ—П—И–љ–Є–є –і–µ–љ—М –∞–ї–≥–Њ—А–Є—В–Љ—Л —Г—З–Є—В—Л–≤–∞—О—В –Њ–≥—А–Њ–Љ–љ–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ —Д–∞–Ї—В–Њ—А–Њ–≤, –≤–ї–Є—П—О—Й–Є—Е –љ–∞ –њ–Њ–Ј–Є—Ж–Є—О —Б—В—А–∞–љ–Є—Ж—Л –≤—Л–і–∞—З–Є. –Ъ –љ–Є–Љ –Њ—В–љ–Њ—Б—П—В—Б—П –Ї–∞–Ї —Д–∞–Ї—В–Њ—А—Л, –Њ—В–љ–Њ—Б—П—Й–Є–µ—Б—П –љ–µ–њ–Њ—Б—А–µ–і—Б—В–≤–µ–љ–љ–Њ –Ї —Б–∞–Љ–Њ–є —Б—В—А–∞–љ–Є—Ж–µ, —В–∞–Ї –Є —Д–∞–Ї—В–Њ—А—Л, –Њ—В–љ–Њ—Б—П—Й–Є–µ—Б—П –Ї–Њ –≤—Б–µ–Љ—Г —Б–∞–є—В—Г.

–Ь–Њ–ґ–љ–Њ –≤—Л–і–µ–ї–Є—В—М 3 –љ–∞–њ—А–∞–≤–ї–µ–љ–Є—П —Д–∞–Ї—В–Њ—А–Њ–≤, –≤–ї–Є—П—О—Й–Є—Е –љ–∞ –њ–Њ–Ј–Є—Ж–Є–Є —Б—В—А–∞–љ–Є—Ж—Л –≤ –≤—Л–і–∞—З–µ:

- –Т–љ—Г—В—А–µ–љ–љ–Є–µ —Д–∞–Ї—В–Њ—А—Л —Б–∞–є—В–∞ (—В–µ–Ї—Б—В—Л –Є —Б—Б—Л–ї–Ї–Є –≤–љ—Г—В—А–Є —Б–∞–є—В–∞)

- –Т–љ–µ—И–љ–Є–µ —Д–∞–Ї—В–Њ—А—Л (—Б—Б—Л–ї–∞—О—Й–Є–µ—Б—П —Б—В—А–∞–љ–Є—Ж—Л –Є —Б–∞–є—В—Л)

- –Я–Њ–≤–µ–і–µ–љ—З–µ—Б–Ї–Є–µ —Д–∞–Ї—В–Њ—А—Л (–і–µ–є—Б—В–≤–Є—П –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М –љ–∞ —Б–∞–є—В–µ, –Ї–∞–Ї–Њ–є —А–µ–Ј—Г–ї—М—В–∞—В –і–Њ–≤–Њ–ї–µ–љ / –љ–µ –і–Њ–≤–Њ–ї–µ–љ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М –њ–Њ–ї—Г—З–µ–љ–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–µ–є).

–Ш—Б—В–Њ—А–Є—П —А–∞–Ј–≤–Є—В–Є—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ. –Ш–Ј–љ–∞—З–∞–ї—М–љ–Њ –њ–µ—А–≤—Л–µ –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л —Г—З–Є—В—Л–≤–∞–ї–Є –ї–Є—И—М –≤–љ—Г—В—А–µ–љ–љ–Є–µ —Д–∞–Ї—В–Њ—А—Л —Б—В—А–∞–љ–Є—Ж. –Ы—О–і–Є —Б–∞–Љ–Є —А–∞–љ–ґ–Є—А–Њ–≤–∞–ї–Є —А–µ–Ј—Г–ї—М—В–∞—В—Л –≤—Л–і–∞—З–Є, –њ—Г—В–µ–Љ –њ—А–Њ—Б–Љ–Њ—В—А–∞ –≤—Б–µ—Е –њ—А–µ–і–ї–∞–≥–∞–µ–Љ—Л—Е —Б—В—А–∞–љ–Є—Ж. –С—Л–ї–Є –і–∞–ґ–µ —В–∞–Ї–Є–µ –≤—А–µ–Љ–µ–љ–∞, –Ї–Њ–≥–і–∞ —Б—В—А–∞–љ–Є—Ж—Л –≤—Л–≤–Њ–і–Є–ї–Є—Б—М –≤ –∞–ї—Д–∞–≤–Є—В–љ–Њ–Љ –њ–Њ—А—П–і–Ї–µ –њ–Њ –Ј–∞–≥–Њ–ї–Њ–≤–Ї—Г.

–Я–µ—А–≤—Л–Љ–Є –њ—А–µ–і–ї–Њ–ґ–Є–ї–Є —Г—З–Є—В—Л–≤–∞—В—М –≤–љ–µ—И–љ–Є–µ —Д–∞–Ї—В–Њ—А—Л (—Б—Б—Л–ї–Ї–Є) –≤ —Б–≤–Њ–Є—Е –∞–ї–≥–Њ—А–Є—В–Љ–∞—Е —А–∞–љ–ґ–Є—А–Њ–≤–∞–љ–Є—П —Б–Њ–Ј–і–∞—В–µ–ї–Є Google –≤ —Б–≤–Њ–µ–є –і–Є—Б—Б–µ—А—В–∞—Ж–Є–Њ–љ–љ–Њ–є —А–∞–±–Њ—В–µ. –£—З–µ—В –≤–љ–µ—И–љ–Є—Е —Б—Б—Л–ї–Њ–Ї –љ–∞ —Б—В—А–∞–љ–Є—Ж—Л —Б–∞–є—В–∞ –±—Л–ї –њ–Њ—Е–Њ–ґ –љ–∞ —Ж–Є—В–Є—А–Њ–≤–∞–љ–Є–µ –≤ –љ–∞—Г—З–љ–Њ–є –і–µ—П—В–µ–ї—М–љ–Њ—Б—В–Є – –І–µ–Љ –±–Њ–ї—М—И–µ –і—А—Г–≥–Є—Е –∞–≤—В–Њ—А–Њ–≤ —Б—Б—Л–ї–∞—О—В—Б—П –љ–∞ –Т–∞—Б, —В–µ–Љ –±–Њ–ї—М—И–Є–є —Г –Т–∞—Б –∞–≤—В–Њ—А–Є—В–µ—В –≤ –≤–∞—И–µ–є –Њ–±–ї–∞—Б—В–Є. –Ґ–∞–Ї–Є–Љ –ґ–µ –Њ–±—А–∞–Ј–Њ–Љ –±–Њ–ї–µ–µ –њ—А–Є–Њ—А–Є—В–µ—В–љ—Л–µ —Б–∞–є—В—Л –і–Њ–ї–ґ–љ—Л –љ–∞—Е–Њ–і–Є—В—М—Б—П –≤—Л—И–µ –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–µ. –≠—В—Г –Є–і–µ—О –њ–µ—А–≤–Њ–є –љ–∞—З–∞–ї–∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –љ–∞ –њ—А–∞–Ї—В–Є–Ї–µ —Б–Њ–Ј–і–∞–љ–љ–∞—П —В–Њ–≥–і–∞ –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ Google, –љ–Њ –≤—Б–Ї–Њ—А–µ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–љ–∞—П –≤ —Б–≤–Њ–Є—Е –∞–ї–≥–Њ—А–Є—В–Љ–∞—Е –Є –≤—Б–µ–Љ–Є –Њ—Б—В–∞–ї—М–љ—Л–Љ–Є –њ–Њ–њ—Г–ї—П—А–љ—Л–Љ–Є –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞–Љ–Є. –Ґ–Њ–≥–і–∞ –ґ–µ –≤ —Б–≤—П–Ј–Є —Б –њ–Њ—П–≤–ї–µ–љ–Є–µ–Љ —Б–њ—А–Њ—Б–∞ –љ–∞ —Б—Б—Л–ї–Ї–Є, –Є—Е –љ–∞—З–∞–ї–Є –њ—А–Њ–і–∞–≤–∞—В—М –Є —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–µ–љ–љ–Њ –њ–Њ–Ї—Г–њ–∞—В—М. –Ґ–Њ–≥–і–∞ –ґ–µ –њ–Њ—П–≤–Є–ї–Є—Б—М –Є –њ–µ—А–≤—Л–µ –±–Є—А–ґ–Є —Б—Б—Л–ї–Њ–Ї, –љ–∞–њ—А–Є–Љ–µ—А, —Е–Њ—А–Њ—И–Њ –љ–∞–Љ –Є–Ј–≤–µ—Б—В–љ–∞—П –±–Є—А–ґ–∞ Sape.

–Т–ї–Є—П–љ–Є–µ —Б—Б—Л–ї–Њ–Ї –љ–∞ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–µ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ —Б–∞–є—В–∞ –≤ –ѓ–љ–і–µ–Ї—Б –Є Google. –С—Л–ї–Њ –≤—А–µ–Љ—П, –Ї–Њ–≥–і–∞ –≤–ї–Є—П–љ–Є–µ —Б—Б—Л–ї–Њ–Ї –±—Л–ї–Њ –Ї–Њ–ї–Њ—Б—Б–∞–ї—М–љ—Л–Љ –љ–∞ –Љ–љ–µ–љ–Є–µ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ –Њ —Б–∞–є—В–µ. –Ґ–Њ–≥–і–∞ –±—Л–ї–Њ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ–Њ–Ј–∞–±–Њ—В–Є—В—М—Б—П –ї–Є—И—М –Њ –љ–∞–ї–Є—З–Є–µ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ–≥–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ —Б—Б—Л–ї–Њ–Ї –љ–∞ —Б–≤–Њ–є —Б–∞–є—В, —З—В–Њ–±—Л –Њ–Ї–∞–Ј–∞—В—М—Б—П –љ–∞ –њ–µ—А–≤—Л—Е –њ–Њ–Ј–Є—Ж–Є—П—Е –≤—Л–і–∞—З–Є. –Ґ–∞–Ї–Є–µ –Љ–µ—В–Њ–і—Л –Њ—В–љ–Њ—Б–Є–ї–Є –Ї —Б–µ—А—Л–Љ –Љ–µ—В–Њ–і–∞–Љ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є—П. –Р –Є–Љ–µ–љ–љ–Њ, –µ—Б–ї–Є —Б—В—А–∞–љ–Є—Ж–∞, –Ї–Њ—В–Њ—А—Г—О –њ—А–Њ–і–≤–Є–≥–∞–ї–Є, –±—Л–ї–∞ «–љ–µ –љ—Г–ґ–љ–∞» –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—О, —В–Њ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П –±—Л–ї–∞ —З–µ—А–љ–Њ–є, –∞ –µ—Б–ї–Є —Б—В—А–∞–љ–Є—Ж–∞ –Њ–Ї–∞–Ј—Л–≤–∞–ї–∞—Б—М –њ–Њ–ї–µ–Ј–љ–Њ–є, —В–Њ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—О –Љ–Њ–ґ–љ–Њ –±—Л–ї–Њ –љ–∞–Ј–≤–∞—В—М –±–µ–ї–Њ–є. –Ґ–Њ–≥–і–∞ –ґ–µ –њ–Њ—П–≤–Є–ї–Є—Б—М —В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л–µ —Б—Б—Л–ї–Њ—З–љ—Л–µ –∞–≥—А–µ–≥–∞—В–Њ—А—Л (SeoPult, Webeffector, Rookee –Є –і—А.), –Ї–Њ—В–Њ—А—Л–µ –±—А–∞–ї–Є –љ–∞ —Б–µ–±—П –≤—Б—О —А—Г—В–Є–љ—Г –њ–Њ –Ј–∞–Ї—Г–њ–Ї–µ, –њ—А–Њ–≤–µ—А–Ї–µ –Є –Њ–њ–ї–∞—В—Л –Њ–≥—А–Њ–Љ–љ–Њ–≥–Њ –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ —Б—Б—Л–ї–Њ–Ї. –°–µ–≥–Њ–і–љ—П, –Ї —Б—З–∞—Б—В—М—О —В–∞–Ї–Є–µ –Љ–µ—В–Њ–і—Л –њ–µ—А–µ—Б—В–∞–ї–Є —А–∞–±–Њ—В–∞—В—М –≤ —Б–≤—П–Ј–Є —Б —Б–Є–ї—М–љ–µ–є—И–Є–Љ –Ј–ї–Њ—Г–њ–Њ—В—А–µ–±–ї–µ–љ–Є–µ–Љ –љ–Є–Љ–Є. –Т–ї–Є—П–љ–Є–µ —Б—Б—Л–ї–Њ–Ї –љ–∞ –њ–Њ–Є—Б–Ї–Њ–≤—Г—О –≤—Л–і–∞—З—Г –љ–Є–Ї–Њ–≥–і–∞ –љ–µ –Є—Б—З–µ–Ј–љ–µ—В, –љ–Њ —Б–µ–≥–Њ–і–љ—П —Б—Б—Л–ї–Ї–Є –њ–µ—А–µ—Б—В–∞–ї–Є –Њ–±–ї–∞–і–∞—В—М –Њ—Б–љ–Њ–≤–љ–Њ–є —А–Њ–ї—М—О –≤ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–Є —Б–∞–є—В–Њ–≤. –С–Њ–ї—М—И–µ–µ –≤–ї–Є—П–љ–Є–µ –Њ–Ї–∞–Ј—Л–≤–∞—О—В –њ–Њ–≤–µ–і–µ–љ—З–µ—Б–Ї–Є–µ —Д–∞–Ї—В–Њ—А—Л, –Ї–Њ—В–Њ—А—Л–µ —В–Њ–ґ–µ –Љ–Њ–ґ–љ–Њ –Є–Љ–Є—В–Є—А–Њ–≤–∞—В—М (—З–µ—А–љ–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П), –љ–Њ –Ї–∞–Ї –Њ–Ї–∞–Ј–∞–ї–Њ—Б—М —Б–і–µ–ї–∞—В—М —Н—В–Њ —Б–ї–Њ–ґ–љ–µ–µ.

–Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –њ–Њ—Б—В–Њ—П–љ–љ–Њ –≤–µ–і—Г—В –±–Њ—А—М–±—Г —Б —З–µ—А–љ—Л–Љ seo. –Т —И—В–∞—В–µ –ѓ–љ–і–µ–Ї—Б–∞ –і–∞–ґ–µ –Є–Љ–µ—О—В—Б—П —Б–њ–µ—Ж–Є–∞–ї—М–љ–Њ –Њ–±—Г—З–µ–љ–љ—Л–µ —Б–Њ—В—А—Г–і–љ–Є–Ї–Є, —В–∞–Ї –љ–∞–Ј—Л–≤–∞–µ–Љ—Л–µ –∞—Б–µ—Б—Б–Њ—А—Л, –Ї–Њ—В–Њ—А—Л–µ –≤—А—Г—З–љ—Г—О –њ—А–Њ—Б–Љ–∞—В—А–Є–≤–∞—О—В –њ–Њ–Є—Б–Ї–Њ–≤—Г—О –≤—Л–і–∞—З—Г –Є —Б—В–∞–≤—П—В –Њ—Ж–µ–љ–Ї–Є —Б—В—А–∞–љ–Є—Ж–∞–Љ, –њ–Њ–њ–∞–≤—И–Є–Љ –љ–∞ –њ–µ—А–≤—Л–µ –Љ–µ—Б—В–∞ –≤—Л–і–∞—З–Є. –≠—В–Є –і–µ–є—Б—В–≤–Є—П –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –і–ї—П —Г—Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤–Њ–≤–∞–љ–Є—П –∞–ї–≥–Њ—А–Є—В–Љ–Њ–≤, —А–∞–±–Њ—В–∞—О—Й–Є—Е –љ–∞ —Б—Е–µ–Љ–∞—Е –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞, –њ—Г—В–µ–Љ –Є—Е –Њ–±—Г—З–µ–љ–Є—П.

–Ъ –њ–Њ–≤–µ–і–µ–љ—З–µ—Б–Ї–Є–Љ –Њ—В–љ–Њ—Б–Є—В—М—Б—П –Љ–љ–Њ–≥–Њ —Д–∞–Ї—В–Њ—А–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ —Г—З–Є—В—Л–≤–∞—О—В—Б—П –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є —Б–Є—Б—В–µ–Љ–∞–Љ–Є, –љ–∞–њ—А–Є–Љ–µ—А: –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –њ—А–Њ—Б–Љ–Њ—В—А–µ–љ–љ—Л—Е —Б—В—А–∞–љ–Є—Ж –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–Љ –љ–∞ —Б–∞–є—В–µ, –≤—А–µ–Љ—П –њ—А–Њ—Б–Љ–Њ—В—А–∞ –Є —В.–і. –Т –Њ—Б–љ–Њ–≤–љ–Њ–Љ –∞–ї–≥–Њ—А–Є—В–Љ—Л —Г—З–µ—В–∞ –њ–Њ–≤–µ–і–µ–љ—З–µ—Б–Ї–Є—Е —Д–∞–Ї—В–Њ—А–Њ–≤ –њ—Л—В–∞—О—В—Б—П –Њ–њ—А–µ–і–µ–ї–Є—В—М —Б—В—А–∞–љ–Є—Ж—Л, –Ї–Њ—В–Њ—А—Л–µ –љ—А–∞–≤—П—В—Б—П –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—О. –Ф–ї—П —В–∞–Ї–Є—Е —Б—В—А–∞–љ–Є—Ж—Л –Є –њ–Њ–≤—Л—И–∞—О—В—Б—П –њ–Њ–Ј–Є—Ж–Є–Є –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є –≤—Л–і–∞—З–µ. –Р –њ–Њ–Ј–Є—Ж–Є–Є —В–µ—Е —Б—В—А–∞–љ–Є—Ж, –Ї–Њ—В–Њ—А—Л–µ –љ–µ –љ—А–∞–≤—П—В—Б—П –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П (–љ–∞–њ—А–Є–Љ–µ—А, –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М –Ј–∞–Ї—А—Л–≤–∞–µ—В —Б—В—А–∞–љ–Є—Ж—Г —Б–∞–є—В–∞ –љ–µ –њ–µ—А–µ–є–і—П –љ–Є –љ–∞ –Њ–і–љ—Г –і—А—Г–≥—Г—О), –љ–∞–Њ–±–Њ—А–Њ—В –њ–Њ–љ–Є–ґ–∞—О—В—Б—П.

–Ь–Њ–і—Г–ї—М 1. –І—В–Њ –љ—Г–ґ–љ–Њ –Ј–љ–∞—В—М, —З—В–Њ–±—Л –љ–∞—Г—З–Є—В—М—Б—П –њ—А–Њ–і–≤–Є–≥–∞—В—М —Б–∞–є—В —Б–∞–Љ–Њ–Љ—Г

- 1.1 –Ъ–∞–Ї —А–∞–±–Њ—В–∞—О—В –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л?

- 1.2 –Ф–ї—П —З–µ–≥–Њ –љ—Г–ґ–љ–∞ –Ї–Њ–љ—В–µ–Ї—Б—В–љ–∞—П —А–µ–Ї–ї–∞–Љ–∞ –Є —З—В–Њ –≤—Л–≥–Њ–і–љ–µ–є —А–∞—Б–Ї—А—Г—В–Ї–∞ —Б–∞–є—В–∞ –≤ –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ–∞—Е –ѓ–љ–і–µ–Ї—Б –Є Google –Є–ї–Є –Ј–∞–Ї–∞–Ј–∞—В—М –Ї–Њ–љ—В–µ–Ї—Б—В–љ—Г—О —А–µ–Ї–ї–∞–Љ—Г?

- 1.3 –Т —З–µ–Љ —Б–Њ—Б—В–Њ–Є—В –њ—А–∞–≤–Є–ї—М–љ–∞—П —А–∞—Б–Ї—А—Г—В–Ї–∞ —Б–∞–є—В–∞ –Є —З—В–Њ —В–∞–Ї–Њ–µ –њ–Њ–Є—Б–Ї–Њ–≤–∞—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П?

–Ь–Њ–і—Г–ї—М 2. –°–Њ—Б—В–∞–≤–ї–µ–љ–Є–µ —Б–µ–Љ–∞–љ—В–Є—З–µ—Б–Ї–Њ–≥–Њ —П–і—А–∞ —Б–∞–є—В–∞.

–Ь–Њ–і—Г–ї—М 3. –Т–љ—Г—В—А–µ–љ–љ—П—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П —Б–∞–є—В–∞.

–Ь–Њ–і—Г–ї—М 4. –Т–љ–µ—И–љ—П—П –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П —Б–∞–є—В–∞.

–Ь–Њ–і—Г–ї—М 5. –Ю—Ж–µ–љ–Ї–∞ —Н—Д—Д–µ–Ї—В–Є–≤–љ–Њ—Б—В–Є —А–∞—Б–Ї—А—Г—В–Ї–Є —Б–∞–є—В–∞ –њ—А–Є –њ–Њ–Љ–Њ—Й–Є –Т–µ–±-–∞–љ–∞–ї–Є—В–Є–Ї–Є.

–Ь–Њ–і—Г–ї—М 6. –§–Є–ї—М—В—А—Л –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —Б–Є—Б—В–µ–Љ.

- –Ф–ї—П –Ї–Њ–Љ–Љ–µ–љ—В–Є—А–Њ–≤–∞–љ–Є—П –≤–Њ–є–і–Є—В–µ –Є–ї–Є –Ј–∞—А–µ–≥–Є—Б—В—А–Є—А—Г–є—В–µ—Б—М